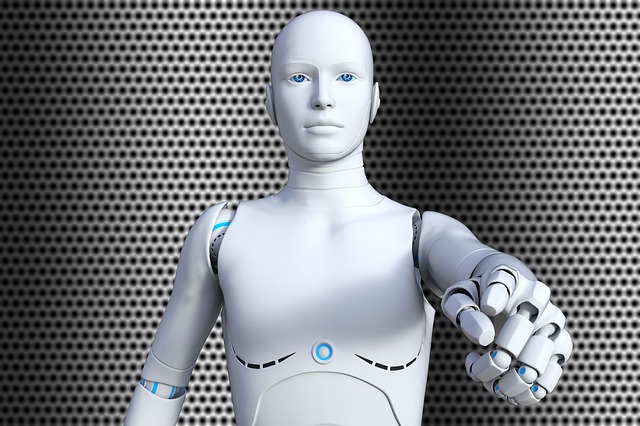

En un estudio reciente se informa que los participantes leen narraciones breves en las que un robot, un robot algo humanoide conocido como iRobot, un robot con una fuerte apariencia humanoide llamado iClooney o un ser humano se encuentra con un problema moral (el dilema del tranvía) donde deben de tomar una decisión específica.

A los participantes también se les mostraron imágenes de estos personajes luego de lo cual evaluaron la moralidad de sus decisiones.

El estudio fue financiado por la Fundación Jane y Aatos Erkko así como por la Academia de Finlandia.

El dilema del tranvía es un problema en el que una persona ve un tranvía corriendo a toda velocidad sobre las vías, sin nadie que lo controle, hacia cinco personas. La persona puede no hacer nada o girar el tren hacia otra vía, salvando a las cinco personas pero matando a otra persona en la otra vía.

Según el estudio, la gente considera que la elección hecha por los humanoides iRobot e iClooney fueron menos éticamente acertadas en comparación a la misma decisión tomada por un humano y un robot con una apariencia tradicional de robot. Michael Laakasuo, investigador principal de la Universidad de Helsinki, líder del proyecto e investigador principal del estudio, vincula los hallazgos con el efecto “valle inquietante”, que ha sido identificado en investigaciones anteriores.

“La humanidad en la inteligencia artificial se percibe como espeluznante, y las actitudes hacia estos robots son más negativas que hacia los robots más parecidos a máquinas. Esto puede deberse, por ejemplo, a la dificultad de reaccionar ante un ser humanoide: ¿es un animal, un humano o una herramienta?

Según Laakasuo, los hallazgos indican que los humanos no encuentran que los robots que toman decisiones morales sean una idea extraña, ya que las decisiones tomadas por un humano y un robot tradicional se consideraban igualmente aceptables. En cambio, la apariencia del robot marca la diferencia en la evaluación de su moralidad.

Laakasuo dice que la cantidad de máquinas inteligentes que toman decisiones morales está creciendo en nuestra sociedad, con los autos autónomos como ejemplo.

“Es importante saber cómo la gente ve las máquinas inteligentes y qué tipo de factores afectan la evaluación moral relacionada. Por ejemplo, ¿las infracciones de tráfico perpetradas por un elegante automóvil autónomo se perciben de manera diferente a las de un modelo menos elegante? «

Este conocimiento puede influir en la dirección del desarrollo de la inteligencia artificial y la robótica, así como, entre otras cosas, en la marca del producto. El conocimiento también puede dar forma a la discusión política relacionada con la regulación de la inteligencia artificial. Por ejemplo, los coches autónomos pueden convertirse en una especie de laboratorio de pruebas para empresas privadas: en el caso de accidentes, las consecuencias se pueden afrontar con dinero, poniendo en riesgo la salud humana en nombre del avance tecnológico con apelaciones a la moral consecuencialista.

“Surgen varias preguntas sobre el tema: ¿Qué tipo de robots queremos tener entre nosotros: robots que salvan a cinco personas de ser atropelladas por un tren, sacrificando a una persona, o ¿robots que se niegan a sacrificar a nadie? ¿Deberían diseñarse los robots para que parezcan humanos o no si su apariencia afecta la moralidad percibida de sus acciones? «

Fuente: Universidad de Helsinki

Referencia:

“Moral Uncanny Valley: A Robot’s Appearance Moderates How its Decisions are Judged” by Laakasuo et al. International Journal of Social Robotics